Compreendendo a Nitidez

A nitidez descreve a clareza de detalhes em uma foto, e pode ser uma ferramenta criativa de muito valor para enfatizar texturas. Técnicas apropriadas de fotografia e pós-processamento podem ajudar muito a melhorar a nitidez de uma imagem, mas, em última análise, ela é limitada por alguns elementos principais: equipamento fotográfico utilizado, tamanho de impressão da imagem e distância de visualização. Dois fatores fundamentais contribuem para a percepção de nitidez em uma imagem: resolução e acutância.

| Acutância | Resolução | |||

|

|

|

|

|

| Alta | Baixa | Alta | Baixa | |

|

A acutância descreve quão rapidamente há transições de informação de imagem em bordas, e assim a alta acutância resulta em transições nítidas e detalhes com bordas bem definidas. |

A resolução descreve a capacidade da câmera de distinguir entre elementos com detalhes não muito espaçados, como os dois conjuntos de linhas mostrados acima. |

Para câmeras digitais, a resolução é limitada pelo seu sensor digital, enquanto que a acutância depende ambos da qualidade das lentes utilizadas quanto da maneira como é feito o pós-processamento da imagem. A acutância é o único aspecto da nitidez que ainda está sob o seu controle depois que a imagem foi feita, então é a acutância que é melhorada quando você aumenta a nitidez de uma imagem por um processo digital.

Comparação

Fotos precisam ter ambas a acutância e a resolução altas para serem ditas 'nítidas'. O exemplo a seguir foi pensado para mostrar melhor como cada uma dessas características influenciam a imagem:

|

|

|

| Acutância: Alta | Resolução: Baixa | |

|

||

| Acutância: Baixa | Resolução: Alta | |

|

||

| Acutância: Alta | Resolução: Alta | |

Propriedades da nitidez

A nitidez também depende de outros fatores que influenciam a nossa percepção visual da resolução e da acutância. O ruído em imagens digitais (ou o grão em filmes) normalmente é prejudicial para a imagem, apesar de pequenas quantidades poderem melhorar a aparência de nitidez. Considere o exemplo a seguir:

|

|

| Pouco ruído, baixa nitidez | Mais Ruído, maior nitidez |

Apesar de nenhuma das imagens terem tido sua nitidez modificadas com uso de software, a da esquerda aparenta ser mais suave e menos detalhada, por ter menos ruído que a outra. O ruído, se for fino e tiver alta acutância, pode enganar os olhos e nos fazer pensar que há detalhes mais nítidos nas imagens.

A nitidez também depende da distância. Imagens que são produzidas para serem vistas de distâncias muito grandes, como posters e outdoors, podem ter uma resolução muito menor que impressões de foto expostas em uma galeria, mas ambas podem ser vistas como nítidas devido a distância. Sempre mantenha isso em mente quando estiver processando as suas imagens, pois o que você precisa não necessariamente é o que tem a melhor aparência na sua tela.

A nitidez também é significativamente afetada pela sua técnica fotográfica. Mesmo as tremidas mais leves podem reduzir dramaticamente a nitidez de uma imagem. Uso de velocidades apropriadas, tripés estáveis e travamento do espelho da câmera também podem ter impacto significativo na nitidez.

Ruído em imagens - Parte 2

Entender as características do ruído em câmeras digitais vai lhe permitir saber como o ruído influencia nas suas fotos. As seguintes seções discutem a variação tonal do ruído, ruído 'chroma' e ruído na luminância e ainda aspectos relacionados a freqüência e magnitude de ruídos em imagens. Exemplos de variações de ruído baseadas em 'ISO' e canais de cor também são mostrados para três câmeras diferentes.

Características

O ruído não muda somente dependendo da exposição da foto e da câmera, mas pode variar dentro de uma mesma imagem. Em câmeras digitais, regiões mais escuras terão mais ruído que regiões mais claras; com filme o oposto é verdade.

|

Cada região ilustrada em tamanho real (100% Zoom) | |||

1 |

2 2 |

3 3 |

4 4 |

|

Note como o ruído se torna menos pronunciado quando os tons se tornam mais claros. Regiões mais claras têm um sinal mais forte pois têm mais luz, resultando uma razão entre sinal e ruído total maior. Isso significa que imagens que estão sub expostas terão ruído muito mais visível -- mesmo se forem clareadas para um nível mais natural. Por outro lado, imagens super expostas terão menos ruído e isso pode ser bem vantajoso, assumindo que seja possível escurecê-las depois e que nenhuma região onde havia textura fique completamente branca (ver "Compreendendo Histogramas, Parte 1").

O ruído é composto de dois elementos: flutuações em cor e em luminância. Ruído colorido ou ruído 'chroma' tem, normalmente, uma aparência menos natural e pode tornar imagens inúteis se não for controlado. O exemplo abaixo mostra o ruído naquilo que era originalmente um quadrado cinza neutro, mostra também os efeitos separados do ruído 'chroma' e luminância.

Ruído na Imagem |

|

Ruído na Luminância |

Ruído 'Chroma' |

A quantidade relativa de ruído 'chroma' e luminância pode variar significativamente de um modelo de câmera para outro. Existem maneiras de reduzir ambos através do uso de softwares, mesmo assim, a eliminação completa do ruído na luminância pode produzir imagens com uma aparência 'plastificada'.

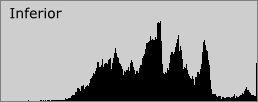

Flutuações no ruído podem variar tanto na magnitude quanto na freqüência espacial, apesar dessa última ser uma característica que normalmente é ignorada. O termo 'grão fino' (em inglês 'fine-grained') é muito usado em relação a filmes para descrever o ruído cujas flutuações ocorrem em distâncias muito curtas, o que é o mesmo que ter uma alta freqüência espacial. O exemplo abaixo mostra como a freqüência espacial pode mudar a aparência do ruído.

|

|

| Ruído de Baixa Freqüência (Textura Bruta) Desvio Padrão: 11.7 |

Ruído de Alta Freqüência (Textura Fina) Desvio Padrão: 12.5 |

Se os dois quadrados acima fossem comparados com base somente na magnitude de suas flutuações (como fazem a maioria dos artigos de revisão de câmeras), então diria-se que o quadrado da direita tem mais ruído. Sob uma rápida inspeção visual, o da esquerda é que parece ter muito mais ruído que o da direita. Isso se deve exclusivamente à distribuição espacial do ruído em cada um dos quadrados.

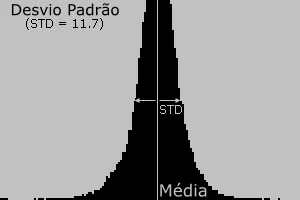

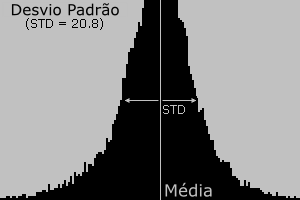

Apesar da freqüência espacial estar sendo enfatizada, a sua magnitude também é importante por ter um efeito notável. O próximo exemplo mostra dois quadrados que têm desvios padrão diferentes, mas a mesma freqüência espacial.

|

|

| Ruído de Baixa Magnitude (Textura Suave) Desvio Padrão: 11.7 |

Ruído de Alta Magnitude (Textura Rugosa) Desvio Padrão: 20.8 |

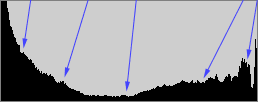

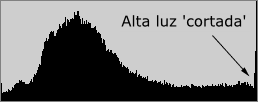

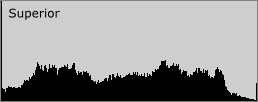

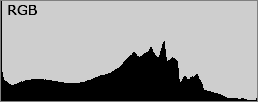

Note como o quadrado da esquerda aparenta ser muito mais suave que o da direita. Ruído de alta magnitude pode se sobrepor a texturas finas como panos ou folhas, e pode ser muito mais difícil de remover sem causar suavização da imagem. A magnitude do ruído normalmente é descrita baseada numa medida estatística chamada 'desvio padrão', que quantifica a variação típica que um pixel tem de seu valor "real". Esse conceito pode ser compreendido inspecionando-se os histogramas de cada um dos quadrados do exemplo anterior:

|

|

| Ruído de Baixa Magnitude | Histograma RGB |

|

|

| Ruído de Alta Magnitude | Histograma RGB |

Se nenhum dos quadrados tivesse ruído, todos os pixels estariam representados por uma linha exatamente no meio do histograma. Conforme o nível de ruído aumenta, a largura desse histograma em forma de sino também aumenta. Apresentamos o histograma RGB, mas a mesma comparação pode ser feita para a luminosidade (a medida mais comum de ruído) e para cada um dos canais de cor. Para mais informações sobre tipos de histogramas, por favor veja: "Compreendendo Histogramas: Luminância e Cor".

Exemplos

é muito útil experimentar com a sua câmera, para que você consiga lidar e saber quanto ruído é gerado em cada opção de 'ISO'. Os exemplos abaixo mostram as características do ruído gerado por três câmeras diferentes ao se fotografar uma imagem teste cinza com diferentes opções de 'ISO'.

| ISO 100 | ISO 200 | ISO 400 | |

| Canon EOS 20D área de cada pixel: 40 µm2 Lançada em 2004 |

|

|

|

| Canon PowerShot A80 área de cada pixel: 9.3 µm2 Lançada em 2003 |

|

|

|

| Epson PhotoPC 800 área de cada pixel: 15 µm2 Lançada em 1999 |

|

|

|

| Ver Canal: | vermelho | verde | azul | todos |

(JPEG de melhor qualidade, balanço de branco em 'luz do dia' e nitidez padrão)

Note as diferenças em cada um dos modelos, canal de cor e 'ISO'. Repare como cada canal de cor tem quantidades bem diferentes de ruído. O canal azul normalmente tem muito mais ruído e o verde tem menos em câmeras que usam 'Bayer arrays'. Note também como a câmera Epson apresenta manchas de cor que são muito mais visíveis que o ruído causado somente por flutuações no brilho.

Você também pode notar como aumentar o 'ISO' sempre produz mais ruído em uma câmera, mas a variação de ruído na troca de 'ISO' muda muito de câmera para câmera. Quanto maior a área de um pixel no sensor da câmera, maior será a capacidade de receber luz -- produzindo assim um sinal mais forte. Como resultado, câmeras com pixels fisicamente maiores geralmente vão aparentar ter menos ruídos, já que o sinal é maior em relação ao ruído. é por isso que câmeras com mais megapixels espremidos em uma mesma área não necessariamente produzem imagens melhores. Por outro lado, um sinal mais forte necessariamente leva a ruídos menos notáveis, já que é a quantidade relativa de ruído e sinal que determina quão ruidosa será uma imagem. Apresar da Epson PhotoPC 800 ter pixels muito maiores que a Canon PowerShot A80, ela tem visivelmente muito mais ruído -- especialmente no 'ISO' 400. Isso acontece pois a Epson em questão é muito mais velha e gerava muito mais ruído, devido ao hardware e software menos sofisticados.

Para mais informações, por favor veja a primeira parte desse tutorial, chamada:

"Ruído em Imagens Digitais: Exemplos e Características"

A percepção das cores

As cores só existem se três componentes estiverem presentes: um observador, um objeto e luz. Apesar da luz branca ser normalmente encarada como "sem cor", na realidade ela contém todas as cores do espectro visível. Quando a luz branca atinge um objeto ele absorve algumas cores e reflete outras; somente as cores refletidas contribuem para a interpretação da cor feita pelo observador.

A percepção das cores: nossos olhos e a visão

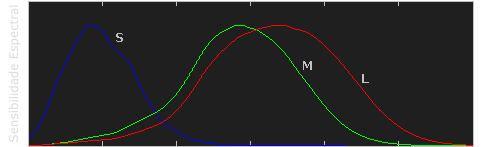

O olho humano sente o espectro de cores usando uma combinação da informação vinda de células localizadas no olho, chamadas de cones e bastonetes. Os bastonetes são mais adaptados a situações de pouca luz, mas eles somente detectam a intensidade da luz, os cones, por outro lado, funcionam melhor com intensidades maiores de luz e são capazes de discernir as cores. Existem três tipos de cones nos nossos olhos, cada um especializado em comprimentos de luz curtos (S), médios (M) ou longos (L). O conjunto de sinais possíveis dos três tipos de cones define a gama de cores que conseguimos ver. O exemplo abaixo ilustra a sensibilidade relativa de cada um dos tipos de células cone para todo o espectro de luz visível -- de ~400nm a 700 nm.

| Selecione Modo: | Células Cone | Luminosidade |

Dados cortesia de 'Colour and Vision Research Laboratories' (CVRL), UCL

Note como cada tipo de célula não só se especializa em uma cor, mas também tem níveis variáveis de sensibilidade ao longo de uma gama de comprimentos de onda. Mova o mouse sobre "luminosidade" para ver quais cores contribuem mais para a percepção de brilho. Note também como a percepção humana de cores é mais sensível a luz na região amarelo-verde do espectro; essa informação é utilizada nas chamadas "bayer arrays" nas câmeras digitais modernas.

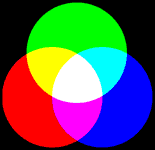

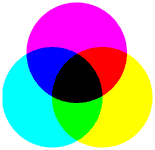

Misturando cores por adição e subtração

Praticamente todas as cores visíveis podem ser produzidas utilizando alguma mistura de cores primárias por combinação aditiva ou subtrativa. O processo aditivo cria cores adicionando luz a um fundo preto, o processo subtrativo usa pigmentos ou tinturas para, seletivamente, bloquear a luz branca. A compreensão de cada um desses processos é a base fundamental para entender a reprodução de cores.

|

|

| Aditivo | Subtrativo |

As cores nos três círculos exteriores são chamadas de primárias e são diferentes em cada um dos diagramas. Aparatos que se baseiam em cores primárias para representar cores só podem produzir uma gama limitada de cores. Os monitores de computador, por exemplo, emitem luz para produzir cores através do processo aditivo; impressoras, por outro lado, usam tinta, ou pigmento, para absorver a luz, através do processo subtrativo. é por isso que a grande maioria de monitores usa uma combinação de pixels vermelho, verde e azul (o que é comumente chamado de RGB, do inglês "red, green and blue"). As impressoras, por sua vez, usam (pelo menos) tintas das cores ciano, magenta e amarelo (o que é chamado de CMY, do inglês "cyan, magenta and yellow"). Muitas impressoras também utilizam a tinta preta (abreviado, nesse caso, por CMYK, onde o K vem de "blacK"), já que uma combinação de CMY não é capaz de produzir preto profundo.

| Mistura de Cor Aditiva | Mistura de Cor Subtrativa | |||||

|---|---|---|---|---|---|---|

| Vermelho + Verde | → | Amarelo | Ciano + Magenta | → | Azul | |

| Verde + Azul | → | Ciano | Magenta + Amarelo | → | Vermelho | |

| Azul + Vermelho | → | Magenta | Amarelo + Ciano | → | Verde | |

| Vermelho + Verde + Azul | → | Branco | Ciano + Magenta + Amarelo | → | Preto | |

Processos subtrativos são mais suscetíveis as mudanças na luz ambiente já que eles dependem dessa luz para produzir as cores. Cores impressas normalmente necessitam de um tipo específico de luz para reproduzir fielmente as cores que são vistas em uma tela.

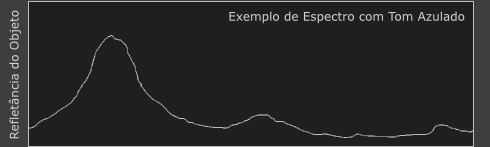

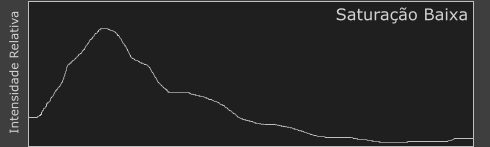

Propriedades da cor: Tom e Saturação

A cor tem dois componentes únicos que a separa da luz acromática: tom e saturação. Descrever cores usando essas termos pode ser altamente subjetivo, mas cada um deles pode ser ilustrado mais objetivamente se inspecionarmos o espectro de cor da luz.

As cores que vemos todos os dias não são compostas de luz de apenas um comprimento de onda, mas contém uma grande gama de comprimentos de onda. O tom de uma cor descreve qual comprimento de onda parece ser o mais dominante. O objeto cujo espectro é mostrado abaixo seria percebido como azulado, mas contém registros de vários outros comprimentos de onda.

A saturação de uma cor é a medida de sua pureza. Uma cor muito saturada é uma cor que contém um conjunto muito estreito de comprimentos de onda e aparenta muita ser muito mais pronunciada que uma cor similar menos saturada. O seguinte exemplo ilustra o espectro para ambos uma cor azul saturada e uma não saturada.

| Selecione o Nível de Saturação: | Baixa | Alta |

Formatos de Imagens

Terminologia: compressão de imagem

Arquivos podem ser 'comprimidos' ou 'não-comprimidos'. Arquivos comprimidos normalmente são consideravelmente menores que seus equivalentes não comprimidos e são separados em duas categorias gerais: "lossy" e "lossless" (do inglês "com perda" e "sem perda", respectivamente). Compressões "lossless" garantem que toda a informação contida na imagem é mantida, então quando ela for descomprimida ela vai ser exatamente igual a original. Compressões "lossy" podem criar imagens sensivelmente menores, mas esse tipo de compressão descarta seletivamente dados da imagem original de modo que a imagem comprimida não é mais idêntica a original. Diferenças visíveis entre arquivos comprimidos e os original são chamadas de 'artefatos de compressão'.

O formato JPEG

JPEG é uma abreviação de "Joint Photographic Expert Group" e, como o nome sugere, foi desenvolvido especificamente para arquivar imagens fotográficas. Ele também se tornou um formato padrão para guardar imagens em câmeras digitais e para muitas das imagens que vemos hoje na internet. Imagens JPEG são bem menores que aquelas salvas no formato TIFF, mas isso vem com um preço, já que as imagens JPEG utilizam compressão "lossy". A compressão utilizada pelo formato JPEG não precisa ser feita da mesma forma para todas as imagens, ou seja, há diversas opções diferentes que podem ser utilizadas ao se comprimir imagens diferentes (sempre levando-se em conta o resultado desejado).

Através do formato JPEG é possível obter arquivos menores comprimindo a imagens de uma forma que mantém o detalhe nas partes da imagem que importam mais e descartando detalhes em partes consideradas menos importantes. O olho humano percebe pequenas mudanças de brilho muito mais facilmente que pequenas mudanças em cor, desse modo, a compensação realizada para criar JPEGs tende a manter o brilho das imagens idêntico ao original. O quão comprimida a imagem final é depende tanto de quanto conteúdo a imagem tem quanto de quão grande é a compressão selecionada pelo usuário.

é muito útil ter uma intuição visual de como os diversos níveis de compressão impactam na qualidade da imagem final, como pode ser visto no exemplo abaixo. Em 100% mal se pode notar qualquer diferença entre a imagem comprimida e o original, se é que há alguma, A partir daí, preste atenção em como o algoritmo utilizado no JPEG prioriza o detalhe em regiões de contraste em oposição a texturas mais sutis. Conforme a qualidade de compressão diminui o algoritmo é forçado a destruir o detalhe nas bordas e texturas com mais e mais contraste, para que o tamanho do arquivo siga diminuindo.

| Escolha uma Qualidade de Compressão: | 100% | 80% | 60% | 30% | 10% | ||

|

|

|

|||||

| IMAGEM ORIGINAL | IMAGEM COMPRIMIDA | ||||||

O formato TIFF

TIFF é uma abreviação de "Tagged Image File Format" e é um padrão nas indústrias de impressão e publicação. Arquivos TIFF são significativamente maiores que os equivalentes em JPEG e podem ser tanto não-comprimidos quanto comprimidos usando métodos "lossless". Ao contrário do JPEG, arquivos TIFF podem ter uma profundidade de bits de 16-bits por canal além do padrão de 8-bits por canal, e ainda podem guardar imagens com múltiplas camadas (ou páginas).

Arquivos TIFF são uma opção excelente para arquivar imagens intermediárias que possam vir a ser editadas no futuro, já que nunca introduz artefatos de compressão. Muitas câmeras têm uma opção para salvar as fotos em TIFF, mas elas vão ocupar muito mais espaço do que se fosse utilizado o JPEG, assim menos fotos poderão ser guardadas num mesmo cartão. Se a sua câmera suporta o formato RAW então essa alternativa é melhor, já que ele é menor e normalmente possui mais que 8-bits por canal de cor.

Dicas úteis

- Só salve imagens utilizando compressão "lossy" uma vez que todo o processo de edição da imagem tenha sido finalizado, já que muitas das manipulações envolvidas em processos de edição podem ampliar os artefatos de compressão.

- Evite comprimir uma mesma imagens muitas vezes repetidamente, já que os artefatos de compressão podem se acumular a degradar a imagem progressivamente. Nesses casos, o JPEG produz imagens cada vez maiores a cada vez que a mesma imagem é re-comprimida, mesmo que o nível de compressão seja o mesmo!

- Quando utilizar JPEG assegure-se que os níveis de ruído das imagens sejam sempre o menor possível, já que imagens com menos ruído produzem JPEGs menores.

Histogramas - Parte 1

Compreender o que são, como funcionam e se familiarizar com os histogramas são provavelmente os passos mais importantes para trabalhar com imagens de uma câmera digital. Um histograma pode dizer se a imagem foi exposta corretamente, se o tipo de luz era dura ou suave e quais ajustes funcionam melhor em sua câmera. Esse conhecimento não só melhora as suas habilidades no computador, mas como fotógrafo também.

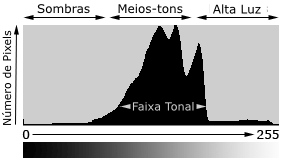

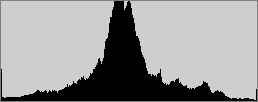

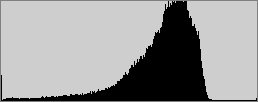

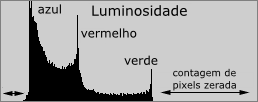

Cada pixel de uma imagem tem uma cor que foi produzida por uma combinação de cores primárias (vermelho, verde e azul, ou RGB). Cada uma dessas cores pode ter um brilho que varia de 0 a 255 em uma imagem digital com profundidade de bits de 8-bits. Um histograma RGB é produzido quando o computador varre a imagem em cada um desses valores de brilho RGB e conta quantos pixels há em cada nível de 0 a 255. Outros tipos de histogramas existem, mas todos têm mais ou menos a mesma cara do exemplo abaixo:

Tons

A região onde a maioria dos valores tonais se encontra é chamada de "gama tonal". A gama tonal pode variar drasticamente de uma imagem para outra, então desenvolver uma intuição em relação a como os números se transformam em valores de brilho é crítico -- ambos antes e depois da foto ser tirada. Não há um "histograma ideal" ao qual as imagens devem seguir; o histograma deve simplesmente seguir a gama tonal que o fotógrafo deseja transmitir.

![]()

A imagem acima é um exemplo que contém uma gama tonal bem ampla, com marcadores que ilustram onde regiões na cena representam os níveis de brilho no histograma. Essa cena costeira contém poucos meios-tons, mas tem grandes regiões de sombras e altas-luzes no canto inferior esquerdo e no superior direito, respectivamente. Isso resulta num histograma que tem uma alta contagem de pixels nos extremos esquerdo e direito.

| A luz normalmente não é tão extrema quanto no exemplo anterior. Condições de luz normal e bem distribuída, quando combinadas com um sujeito bem exposto, normalmente produzem um histograma cujo pico encontra-se no centro e que gradualmente diminui em direção às regiões de alta e baixa luzes aos lados. Com exceção da luz do sol refletida diretamente no topo do prédio e algumas janelas, a cena com o barco ao lado possui luz bem distribuída. A maioria das câmeras não encontrará problemas para reproduzir automaticamente uma imagem que possui histograma similar ao mostrado abaixo. |  |

|

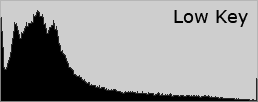

Imagens com 'low key' e 'high key'

Apesar da maioria das câmeras, quando no modo automático, produzirem histogramas com pico no meio-tom, a distribuição dos picos num histograma depende da gama tonal da imagem. Imagens onde a maioria dos tons está na região das baixas luzes (ou sombras) são chamadas de 'low key' (uma tradução literal seria 'chave baixa', mas o termo normalmente não é traduzido), enquanto que imagens com 'high key' (chaves altas) têm a maioria dos tons nos brilhos.

|

|

|

|

Antes de tirar uma foto, é útil determinar se o sujeito se qualifica como 'low' ou 'high key'. Já que as câmeras medem a luz refletida, elas são incapazes de dizer o brilho absoluto dos sujeitos da imagem. Como resultado, muitas câmeras possuem algoritmos avançados para esquivar essa limitação, e estimar quanto brilho a imagem deve ter. Essas estimativas normalmente produzem imagens cujo brilho médio encontra-se nos meios-tons. Isso é, freqüentemente, aceitável, mas cenas com 'low' ou 'high key' pronunciados necessitam de ajustes de exposição manuais do fotógrafo para corrigir o palpite da câmera. Uma boa regra para ter em mente é: você normalmente precisa ajustar a exposição quando quer que o brilho médio das suas imagens esteja mais escuro ou mais claro que os meios-tons.

O seguinte grupo de imagens é o resultado obtido automaticamente pela câmera para as fotos mostradas anteriormente. Note como a média de contagem de pixels é trazida para os meios-tons.

|

|

|

|

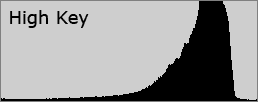

A maioria das câmeras digitais são melhores reproduzindo cenas com 'low key' pois elas previnem que qualquer região da imagem tenha brilho suficiente para se tornar branco puro, independente de quão escuro o resto da imagem possa resultar. Cenas com 'high key', por outro lado, normalmente resultam em imagens significativamente sub-expostas. Mas é mais fácil lidar com regiões sub-expostas do que com as super-expostas (apesar disso comprometer a razão entre o sinal e o ruído). O detalhe não pode ser recuperado caso a região esteja super-exposta a ponto de ser branco puro. Quando isso ocorre a alta luz é dita estar 'estourada' ou 'cortada'.

|

|

O histograma é uma boa ferramenta para saber se o corte ocorreu, já que é possível ver diretamente se o brilho está empurrado para um dos lados do gráfico. Um pouco de corte pode ser normal em regiões como reflexões especulares na água ou meta, ou quando o sol ou outras fontes luminosas muito fortes estão enquadradas. Em última análise, a quantidade de corte depende do fotógrafo e o que ele deseja transmitir.

Contraste

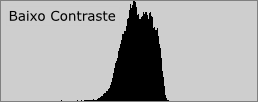

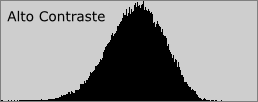

Um histograma também pode descrever quanto contraste há numa imagem. Contraste é uma medida da diferença de brilho entre as áreas claras e escuras de uma cena. Histogramas largos são típicos de cenas com bastante contraste, enquanto histogramas estreitos são de imagens com menos contraste e que podem aparentar achatadas ou sem graça. Isso pode ser causado por uma combinação de fatores de luz e sujeito. Fotos tiradas em condição de neblina ou fumaça terão baixo contraste; fotos tiradas sob sol forte, por outro lado, terão contraste muito mais alto.

|

|

|

|

O contraste pode ter um impacto visual muito grande ao enfatizar texturas, como mostrado na imagem acima. O alto contraste da água tem sombras mais profundas e brilhos mais pronunciados, criando texturas que saltam aos olhos de quem as observa.

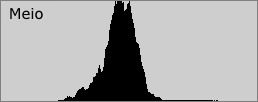

O contraste também pode variar de acordo com a região de uma mesma imagem se houver diferentes condições de luz e sujeito nela. Podemos dividir a imagem do barco mostrada anteriormente em três regiões -- cada uma com um histograma diferente.

|

|

|

|

|

A região no topo contém mais contraste que as outras três pois a imagem é criada a partir de luz que reflete diretamente dos objetos. Isso produz sombras mais profundas logo abaixo do barco e brilhos mais fortes nas áreas acima e expostas. As regiões do meio e de baixo são inteiramente produzidas por luz difusa, luz refletida da superfície da água e, por isso, têm menos contraste; como se a foto fosse tirada sob neblina. A região de baixo tem mais contraste do que a do meio -- apesar de apresentar um céu com um só tom de azul -- isso porque ela contém uma combinação de sombra e luz intensa do sol. As condições de luz na parte de baixo criam brilhos mais pronunciados, mas mesmo assim ela não apresenta as sombras profundas da região do topo. A soma dos histogramas das três regiões produz o histograma geral mostrado anteriormente.

Para mais informações sobre histogramas, por favor visite: "Histogramas - Luminância e Cor"

Ruído em Imagens de Câmeras Digitais - Parte 1

"Ruído" é o equivalente digital dos grãos dos filmes utilizados em câmeras analógicas. Alternativamente, pode-se pensar nele como o equivalente ao sutil chiado que se percebe quando uma música é ouvida num volume muito alto. Para as imagens digitais, esse ruído aparece como manchas aleatórias em uma superfície originalmente suave e pode degradar a qualidade da imagem significativamente. Apesar do ruído normalmente ser um ponto fraco em uma imagem, ele pode também ser desejado, já que pode conferir à imagem um aspecto antigo e que lembre filmes. Um pouco de ruído também pode aumentar a nitidez da imagem. O ruído aumenta proporcionalmente à sensibilidade escolhida, duração da exposição e temperatura. A quantidade de ruído também depende muito da câmera utilizada para gerar a imagem, câmeras profissionais de alto nível costumam ter muito menos ruído que câmeras compactas comuns.

Conceitos

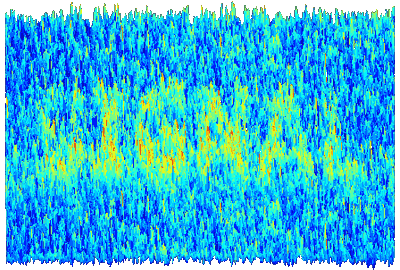

Algum grau de ruído sempre está presente em qualquer aparelho eletrônico que transmite ou recebe um 'sinal'. Para as televisões esse sinal são os dados da transmissão enviados por cabo ou recebidos pela antena da TV; para as câmeras digitais, o sinal é a luz que atinge o sensor da câmera. Mesmo sendo inevitável, o ruído pode se tornar tão pequeno relativamente ao sinal que pode ser considerado inexistente. A razão entre o sinal e o ruído (SNR, do inglês 'signal to noise ratio') é uma maneira útil e universal de comparar as quantidades relativas de sinal e ruído para qualquer sistema eletrônico; razões altas terão pouco ruído visível enquanto o oposto vale para baixas razões. A seqüência de imagens abaixo mostra uma câmera produzindo uma figura com muito ruído da palavra 'signal' contra um fundo suave. A imagem resultante é mostrada junto com uma representação 3D mostrando o sinal sobre o ruído de fundo.

Imagem Original Imagem na Câmera |

|

|

| Representação 3-D Colorida da Imagem da Câmera | ||

A imagem acima tem uma SNR significativamente alta de modo que é possível separar a informação da imagem claramente. Uma SNR baixa produziria uma imagem onde a palavra 'signal' e o ruído são comparáveis e, assim, muito mais difíceis de serem discernidos um do outro.

| Imagem na Câmera |

|

Terminologia

O "ISO" de uma câmera (em inglês "ISO setting" ou "ISO speed") é um padrão que descreve a sua sensibilidade absoluta à luz. O 'ISO' normalmente é listado em fatores de 2, como ISO 50, ISO 100 e ISO 200 e pode ter uma grande variedade de valores. Valores mais altos representam maior sensibilidade e a razão entre dois valores de 'ISO' representa a sensibilidade relativa entre elas, ou seja, uma foto com ISO 200 demorará a metade do tempo que uma foto com ISO 100 para atingir o mesmo nível de exposição (se todos os outros parâmetros da câmera forem fixados). O 'ISO' das câmeras digitais é a mesma coisa que a 'ASA' encontrada nos filmes para câmeras analógicas; claro que a diferença é que uma única câmera digital pode fotografar em diferentes 'ISO' sem troca de filmes. O aumento do 'ISO' é possível amplificando-se o sinal do sensor da câmera, mas isso também amplifica o ruído, assim, quanto maior o 'ISO', mais ruído a imagem apresenta.

Tipos de ruído

Câmeras digitais produzem três tipos mais comuns de ruído: aleatório, de 'padrão fixo' e de bandas. As três imagens abaixo mostram exemplos qualitativos pronunciados de casos isolados de cada um dos tipos de ruído contra um fundo cinza.

|

|

|

| Ruído com Padrão Fixo Exposição Longa Baixo ISO |

Ruído Aleatório Exposição Curta Alto ISO |

Ruído em Bandas Câmera Suscetível Sombras Clareadas |

O ruído aleatório é caracterizado por flutuações de intensidade e tom de cor em relação a imagem real. Sempre haverá alguma quantidade de ruído aleatório em qualquer duração de exposição e ela será muito influenciada pelo 'ISO'. O padrão do ruído aleatório muda mesmo quando as propriedades da exposição são as mesmas (é exatamente por isso que ele é chamado de 'aleatório').

O ruído de padrão fixo inclui o que se costuma chamar de 'hot pixels' (do inglês: 'pixels quentes'), que são chamados assim quando a intensidade de um pixel ultrapassa muito a das flutuações de ruído aleatório. O ruído de padrão fixo geralmente aparece em situações de exposições longas e é exacerbado por temperaturas altas. Uma característica importante é que ele mostra aproximadamente a mesma distribuição se as condições nas quais a imagem é produzida são a repetidas (temperatura, exposição e 'ISO').

O ruído em banda depende muito da câmera utilizada e é introduzido pela própria câmera quando quando ela lê dados provenientes do sensor digital. Ele é mais notável quando são usados 'ISO' altos e nas áreas de baixa luz, ou quando uma imagem foi clareada excessivamente. Dependendo da câmera ele também pode ser aumentado em função do balanço de branco escolhido.

Apesar de parecer ser o mais intrusivo, o ruído de padrão fixo é normalmente o mais fácil de ser removido, devido a sua natureza repetitiva. A eletrônica da câmera tem que simplesmente saber o padrão e subtraí-lo da imagem capturada para revelar a imagem verdadeira. O ruído de padrão fixo é um problema muito menor que o ruído aleatório em câmeras de última geração, apesar de pequenas quantidades ainda serem ainda mais facilmente percebidas que o ruído aleatório.

O ruído aleatório é muito mais complicado de ser removido sem que a imagem seja danificada. Os algoritmos criados para isso ainda lutam para conseguir discernir entre o ruído e texturas reais como as que ocorrem na terra ou folhas, assim tentativas de remover o ruído acabam removendo essas texturas também.

Para mais informações sobre ruído em imagens veja a segunda parte desse tutorial em:

"Ruído em imagens - Exemplos e Características"

Profundidade de Campo

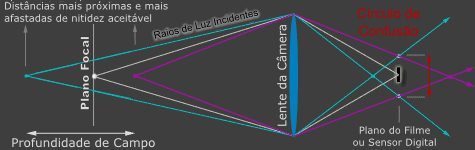

A profundidade de campo é gama de distâncias em torno do plano focal na qual há nitidez aceitável. A profundidade de campo depende dos tipos de câmeras, aberturas e distância, apesar de também ser influenciada pelo tamanho da impressão e pela distância de visualização da imagem. Essa seção foi pensada para ajudar a melhorar a compreensão intuitiva e técnica de profundidade de campo aplicada na fotografia.

|

|

A profundidade de campo não muda em nenhuma região da imagem de modo abrupto, ou seja, em nenhum ponto observa-se transição de nitidez total para desfoque, sempre ocorre uma transição gradual. Na verdade, tudo imediatamente em frente ou atrás do plano de foco já começa a perder nitidez -- mesmo que não percebamos com nossos olhos ou pela resolução da câmera.

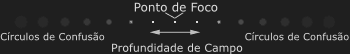

Círculo de confusão

Já que não existe um ponto crítico de transição, um termo mais rigoroso chamado de 'círculo de confusão' é usado para definir quanto um ponto precisa estar borrado para ser visto como desfocado. A região onde o círculo de confusão se torna perceptível está fora da profundidade de campo e então não é mais 'aceitavelmente nítida', isto é, está fora de foco. O círculo de confusão acima teve o tamanho exagerado para ficar mais claro; na realidade ele teria um tamanho equivalente a uma pequena fração da área do sensor da câmera.

Quando que um círculo de confusão se torna perceptível aos nossos olhos? Um círculo de confusão aceitavelmente nítido é definido de uma maneira não muito rigorosa como um que não é percebido se observado a uma distância de 30 cm e numa impressão padrão de 20x25 cm.

Considerando essas distância e tamanho, os fabricante de câmera assumem que um círculo de confusão é irrelevante quando não é maior que 0.2mm. Como resultado, os fabricantes de câmera usam esse padrão quando mostram os marcadores de profundidade de campo em lentes (ver imagem ao lado). Na realidade, uma pessoa com uma visão 'normal' pode discernir elementos com 1/3 desse tamanho ou menores, assim o círculo de confusão deve ser ainda menor do que 0.2mm para produzir nitidez aceitável.

Há um círculo de confusão máximo diferente para cada tamanho de impressão e distância de visualização da mesma. No exemplo anterior com os pontos borrados, o círculo de confusão é, na realidade, menor que a resolução da sua tela para os dois pontos mais próximos ao ponto de foco, e por isso eles são considerados dentro da profundidade de campo. Isso significa que a profundidade de campo pode ser baseada em onde o círculo de confusão se torna menor que o tamanho de um pixel do sensor da sua câmera digital.

Note que a profundidade de campo só determina um valor máximo para o círculo de confusão, e não descreve o que acontece em regiões quando elas estão fora de foco. Essas regiões são chamadas de 'bokeh' (do japonês, pronuncia-se 'bou'-'quei'). Duas imagens com profundidade de campo idênticas podem ter bokeh muito diferentes uma da outra, já que isso depende da forma do diafragma da lente. Na realidade, o círculo de confusão não é um círculo, mas normalmente pode ser aproximado por um já que é pequeno próximo ao ponto de foco. Quando ele se torna grande, a maioria das lentes geram uma forma poligonal com algo entre 5 a 8 lados.

Controlando a profundidade de campo

Apesar do tamanho de impressão e a distância de visualização serem fatores importantes que influenciam na aparência do círculo de confusão para os nossos olhos, a abertura e a distância focal são dois elementos chave que determinam quão grande o círculo de confusão será no sensor da sua câmera. Aberturas maiores (números F menores) e distâncias de foco mais próximas produzem profundidades de campo mais rasas. O seguinte teste de profundidade de campo foi feito variando-se a abertura, mas com a distância de foco fixa e com uma lente de 200mm numa câmera digital com um sensor com fator de corte de 1.6X (ou seja, a lente é equivalente a uma de 320mm em uma câmera de 35mm):

|

|

|

| f/8.0 | f/5.6 | f/2.8 |

Esclarecendo: distância focal e profundidade de campo

Note como a distância focal não foi mencionada como um fator que influencia a profundidade de campo. Mesmo que as câmeras teleobjetivas aparentem criar uma profundidade de campo muito mais rasa, isso se deve principalmente ao fato delas normalmente serem usadas para fazer com que o sujeito da foto aparente ser maior quando o fotógrafo não consegue se aproximar dele. Se o sujeito ocupar a mesma fração do visor da câmera (magnificação constante) para ambos uma lente grande angular e uma teleobjetiva, a profundidade de campo total é praticamente* a mesma com a distância focal! Isso, é claro, obrigaria a uma proximidade muito maior com a lente grande angular ou uma distância muito grande com a teleobjetiva, como é demonstrado na seguinte tabela:

| Distância Focal (mm) | Distância de Foco (m) | Profundidade de Campo (m) |

|---|---|---|

| 10 | 0.5 | 0.482 |

| 20 | 1.0 | 0.421 |

| 50 | 2.5 | 0.406 |

| 100 | 5.0 | 0.404 |

| 200 | 10 | 0.404 |

| 400 | 20 | 0.404 |

Obs.: Os cálculos de profundidade de campo foram feitos usando-se como referência uma Canon 20D (fator de corte 1.6X), uma abertura de f/4.0 e um círculo de confusão de 0.0206 mm.

Perceba como há realmente uma sutil mudança para as menores distâncias focais. Isso é um efeito real, mas é desprezível quando comparado com a abertura e a distância de foco. Mesmo a profundidade de campo total sendo praticamente desprezível, a fração de profundidade de campo que está em frente e atrás da distância de foco muda com a distância focal, como vemos abaixo:

| Distribuição da Profundidade de Campo | ||

|---|---|---|

| Distância Focal (mm) | Trás | Frente |

| 10 | 70.2 % | 29.8 % |

| 20 | 60.1 % | 39.9 % |

| 50 | 54.0 % | 46.0 % |

| 100 | 52.0 % | 48.0 % |

| 200 | 51.0 % | 49.0 % |

| 400 | 50.5 % | 49.5 % |

Isso mostra uma limitação do conceito tradicional de profundidade de campo: ele só leva em conta a profundidade de campo total e não sua distribuição em torno do plano de foco, mesmo que ambos contribuam para a percepção de nitidez. Uma lente grande angular tem uma transição mais gradual da profundidade de campo atrás do plano de foco do que na frente, o que é importante para fotografias de paisagens.

Por outro lado, quando um objeto numa distância fixa é focado a partir de um mesmo local, uma lente com distância focal maior terá uma profundidade de campo menor (apesar das imagens aparentarem algo completamente diferente). Isso é mais próximo ao uso diário dos diferentes tipos de lentes, mas é um efeito devido a magnificação e não distância focal. Lentes com distâncias focais maiores também aparentam ter uma profundidade de campo menores pois eles achatam a perspectiva. Isso resulta em fundos muito maiores relativamente ao primeiro plano -- mesmo se não há mais detalhe. A profundidade de campo também aparenta ser menor para câmeras SLR do que para compactas digitais pois as SLR necessitam menores distâncias focais para atingir o mesmo campo de visão.

*Nota: descrevemos a profundidade de campo como 'quase' constante pois há casos limite onde isso não é verdade. Para distâncias de foco que resultam em maior magnificação, ou muito próximas da 'distância hiperfocal', lentes grande angulares podem ter profundidades de campo maiores que teleobjetivas. Por outro lado, para situações de grande magnificação, os cálculos tradicionais de profundidade de campo se tornam imprecisos por outro fator: magnificação da pupila. Na realidade isso age contra o aumento de profundidade de campo para a maioria das grandes angulares, e a favor para as teleobjetivas e macro. No outro caso limite, próximo da distância hiperfocal, o aumento da profundidade de campo surge devido ao fato das grandes angulares terem maior profundidade de campo atrás do plano de foco, e assim podem alcançar nitidez maior no infinito para qualquer distância de foco.

Calculando a profundidade de campo

Para calcular a profundidade de campo é necessário decidir valores para o máximo círculo de confusão permissível. Isso se baseia tanto no tipo de câmera (tamanho do sensor ou filme) quanto na combinação entre a distância de visualização e o tamanho da impressão.

Cálculos de profundidade de campo normalmente assumem que é necessário haver elementos com tamanho de 0.02cm para que a nitidez seja aceitável (como discutido anteriormente), mas pessoas com visão 20/20 podem ver elementos com 1/3 desse tamanho. Se você usar esse padrão, lembre-se que as partes próximas aos limites do campo podem não estar aceitavelmente nítidas. A calculadora de profundidade de campo abaixo assume esse padrão de visão, mas há outras.

Profundidade de foco

Outra implicação do círculo de confusão é o conceito de profundidade de foco (também chamado de espalhamento de foco). Ele difere da profundidade de campo pois descreve a distância sobre a qual a luz é focalizada no sensor da câmera, em oposição a quanto do sujeito da foto está em foco. Isso é importante pois define a tolerância sobre quão plano deve ser o filme ou o sensor digital para que haja foco em todas as porções da imagem.

Outras notas

Por quê não utilizar a menor abertura (maior número F) para alcançar a maior profundidade de campo? Além do fato de que isso normalmente requer tempos de exposição muito longos e proibitivos sem um tripé, abertura muito pequenas suavizam as imagens criando um círculo de confusão grande (ou "disco de Airy") devido a um efeito chamado de difração -- mesmo dentro do plano de foco. A difração se torna um efeito limitante quando as aberturas diminuem. Apesar de suas profundidades de campo absurdas, normalmente é por isso que as câmeras pinhole têm resolução limitada.

Para fotografia macro (de alta magnificação), a profundidade de campo é influenciada por outro fator: magnificação da pupila. Esse é igual a um para lentes que são simétricas internamente, mas para teleobjetivas é muito menos e para grandes-angulares é muito mais que um. Uma maior profundidade de campo pode ser atingida (em relação ao que se calcula) quando a magnificação da pupila é menos que um, (e não muda quando esse valor é igual a um). O problema é que a magnificação da pupila normalmente não é dada pelos fabricantes de lentes, assim só é possível estabelecê-lo (aproximadamente) visualmente.

Outros sites e leituras

- Norman Koren possuium outra perspectiva sobre a profundidade de campo (em inglês), incluindo muitas equações para os cálculos dela e do círculo de confusão

- The Luminous Landscape compara a profundidade de campo para diferentes distâncias focais (em inglês)-- e dá uma prova visual que a profundidade de campo não muda com a distância focal.

Histogramas - Luminância e Cor em Histogramas

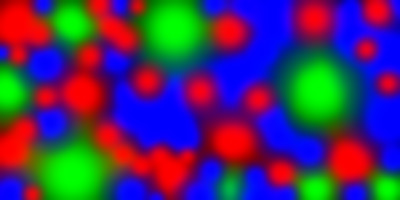

Essa seção deve lhe proporcionar uma melhor compreensão de como ambos a luminância e a cor variam numa imagem, e como isso se traduz de maneira relevante no histograma. Apesar dos histogramas RGB serem os mais comumente usados, outros tipos de histogramas são mais úteis para propósitos mais específicos. A imagem abaixo é mostrada junto com vários outros tipos de histogramas.

Passe o mouse por cima dos rótulos abaixo para mudar qual cor o histograma representará. Quando você mudar para cada uma das cores, a imagem também mudará, essa nova imagem é a representação em tons de cinza da distribuição das intensidades da cor selecionada na imagem. Preste atenção em como cada uma das cores influencia a distribuição de brilho na imagem e como as cores em cada região influenciam no brilho.

|

|

|

|

||

| Escolha: | vermelhoverdeazultodos | |

|

||

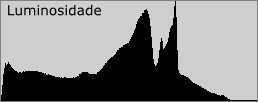

Histogramas de Luminância

Histogramas de luminância são mais precisos que histogramas RGB ao descrever a percepção de distribuição de brilho, ou 'luminosidade' em uma imagem. A luminância leva em consideração o fato de que o olho humano é muito mais sensível a luz verde do que a vermelha ou a azul. Veja o exemplo anterior novamente e repare como os níveis de intensidade do canal verde são mais representativos da distribuição de brilho da imagem com todas as cores. Isso também se reflete pelo fato do histograma da luminância ser mais parecido com o histograma do verde que os outros. A análise de luminância prevê que o seguinte gradiente tem uma luminosidade que gradualmente aumenta em direção ao verde, enquanto que uma simples soma de cada valor de RGB resultaria em intensidades iguais em cada retângulo.

| mais escuro | mais claro |

Como é produzido um histograma de luminância? Primeiro cada pixel é convertido de modo a representar a luminosidade baseada em uma média com pesos diferentes para cada uma das cores em cada pixel. Esses pesos assumem que o verde representa 59% da luminosidade percebida, enquanto que o vermelho e o azul representam apenas 30% e 11%, respectivamente. Mova o mouse sobre "converter para luminosidade" no exemplo acima para ver o resultado desse cálculo quando ele é realizado em cada um dos pixels. Uma vez que cada pixel foi convertido em luminosidade, um histograma de luminância é produzido ao se contar quantos pixels estão em cada valor de luminância -- da mesma forma que os histogramas para cada cor RGB é produzido.

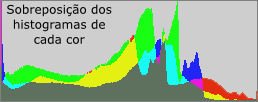

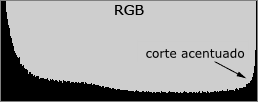

Uma diferença importante que pode-se perceber a partir dos cálculos acima é que enquanto um histograma de luminância retém informação a respeito da localização de cada pixel de cor, o histograma RGB descarta essa informação. O histograma RGB cria três histogramas diferentes e, depois, os soma, descartando a informação que indica se cada contagem de cor veio ou não do mesmo pixel. Para ilustrar melhor esse conceito vamos usar uma imagem cujos dois tipos de histogramas são bem diferentes.

|

|

A imagem acima contém diversas manchas de cor pura. No interior de cada mancha a intensidade alcança um máximo de 255, então há um corte de cor significativo em cada uma das manchas (apesar de ser somente na cor da mancha). Mesmo a imagem não contendo nenhum pixel branco, o histograma RGB mostra um corte pronunciado -- assim, se essa fosse uma foto e estivéssemos fazendo uma análise através somente do histograma, diríamos que está super-exposta. Isso acontece pois o histograma RGB não leva em consideração o fato de que cada um dos cortes de cor não acontece no mesmo lugar.

O histograma da luminância conta uma história completamente diferente ao mostrar que não há nenhum pixel nem perto do brilho máximo. Ele também mostra três picos distintos -- uma para cada cor que foi cortada. Já que a imagem contém mais azul, depois vermelho e pouco verde, as alturas relativas de cada um dos picos nos mostra também qual pico corresponde a qual cor. Note também como a posição de cada pico corresponde a posição das porcentagens utilizadas como pesos para o cálculo da média da luminância: 59%, 30% e 11%.

Então, qual dos histogramas é melhor? Se estivermos interessados em corte de cores, então o RGB é útil pois claramente nos mostra se há corte ou não; o histograma de luminância, por outro lado, não dá nenhuma pista quanto a cortes de cor. Ainda assim, o histograma de luminância nos diz precisamente que não há nenhum pixel inteiramente branco nem nenhum inteiramente preto. Cada um dos histogramas tem seu uso e o mais indicado é aprender a usá-los conjuntamente. Já que a maioria das câmeras mostra somente um histograma RGB, lembre-se sempre das suas desvantagens ao analisar as imagens usando somente o histograma como base. Como regra geral vale que quanto mais intensas e puras forem as cores da imagem, mais os histogramas RGB e de luminância vão variar. Preste atenção especial quando o seu sujeito contém fortes tons de azul, já que é difícil perceber cortes no canal azul usando histogramas de luminância.

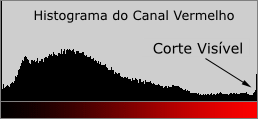

Histogramas de cor

Enquanto os histogramas RGB e de luminância usam todos os três canais de cor, um histograma de (uma) cor descreve a distribuição de brilho para qualquer uma das cores individualmente. Isso pode ser bem mais útil quando se quer determinar se há ou não corte em uma cor específica.

| Ver Canal: | vermelho | verde | azul | todos | luminosidade |

|

|

||

| Ver Histograma: | RGB | luminosidade | |

As pétalas das flores vermelhas estavam sob luz do sol direta, então o vermelho delas foi cortado, mesmo que o resto da imagem tenha permanecido dentro do histograma. Regiões onde os canais de cor individuais são cortados perdem toda a textura gerada por essa cor. Mesmo assim essas regiões cortadas podem manter um pouco de textura caso as outras cores não tenham sido cortadas. O corte individual de cor não é tão problemático quanto o corte de todas as cores, apesar disso ser uma escolha do fotógrafo e do que ele deseja transmitir.

Histogramas RGB podem mostrar se houve corte de cores, mas eles não mostram se isso aconteceu com todas as cores ou alguma cor em particular. Os histogramas de cor melhoram essa análise ao mostrar exatamente o tipo de cor que foi cortada. Mova o mouse sobre os rótulos da imagem acima para comparar os histogramas RGB e de luminância, para ver a imagem em termos de apenas um canal de cor e para ver a imagem como luminância. Note como a distribuição de intensidade para cada canal de cor varia drasticamente em regiões de cor quase puras. A intensidade e a pureza das cores dentro da imagem fazem com que os histogramas RGB e de luminância variem bastante.

Para mais informações sobre histogramas, por favor veja: "Histogramas - Tons e Contraste"

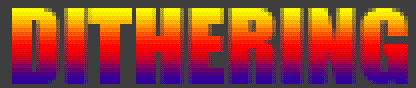

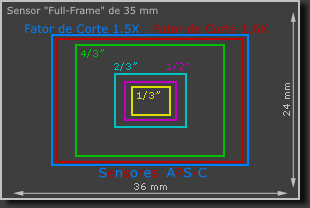

Básico sobre pixels em câmeras digitais

O crescente avanço da tecnologia de câmeras digitais pode gerar muita confusão já que muitos termos novos são introduzidos freqüentemente. Esse tutorial tem como objetivo esclarecer um pouco essa confusão de pixels digitais -- especialmente para os que estão pensando em (ou acabam de) comprar a sua primeira câmera digital. Conceitos como tamanho do sensor, megapixels, 'dithering' e tamanhos de impressão serão discutidos.

O PIXEL: Uma unidade fundamental para todas as imagens digitais

Todas as imagens digitais são constituídas por um mesmo elemento no seu nível mais básico: o pixel. A palavra vem da junção das palavras "PICture" e "ELement", que significam "imagem" e "elemento", respectivamente. Da mesma forma que o movimento pontilista usa uma série de pequenas 'manchas' de tinta para formar uma imagem, milhões de pixels podem ser combinados para criar uma imagem detalhada e aparentemente continua.

| Mova o mouse sobre cada item para selecionar: | Pontilismo | Pixels | |

|

|

||

Cada pixel contém uma série de números que descrevem a sua cor ou intensidade. A precisão com a qual cada pixel pode especificar sua cor é chamada de "profundidade de bit" ou "profundidade de cor". Quanto mais pixels uma imagem tem, maior a capacidade de representar detalhes ela tem. Note o uso da palavra 'capacidade'; o simples fato de ter mais pixels não significa necessariamente que eles são utilizados por completo. Esse fato é muito importante e voltaremos a ele depois.

Tamanho de impressão: pixels por polegada e pontos por polegada

Já que um pixel é só uma unidade de informação lógica ela é inútil para descrever tamanhos de impressões no mundo real -- a menos que seja especificado o tamanho de cada pixel. Os termos pixel por polegada (PPI, do inglês 'pixels per inch') e pontos por polegada (DPI, do inglês 'dots per inch') foram ambos introduzidos para relacionar essa unidade 'teórica' (a dos pixels) com uma resolução visual real. Esses termos costumam ser errôneamente trocados (especialmente quando se fala em impressoras de jato de tinta) -- levando à uma confusão quanto a resolução máxima de impressão de um aparelho.

"Pixel por polegada" é o mais simples dos dois termos. Ele descreve exatamente o que diz: quantos pixels uma imagem contém por cada polegada de distância na horizontal e na vertical. "Pontos por polegada" pode parecer simples a princípio. A complicação surge pois um aparelho pode necessitar diversos pontos para criar um único pixel; desse modo, um dado número de pontos por polegada nem sempre leva a mesma resolução em dois aparelhos diferentes. Usar diversos pontos para criar cada um dos pixels é um processo chamado de 'dithering'.

|

||

|

Um aparelho com um número limitado de cores de tinta pode enganar o olha ao colocá-las em pequenos padrões -- assim o aparelho cria a impressão de diversas cores se cada um dos 'sub-pixels' que cria para cada pixel real é pequeno o suficiente (esse processo pode ser visto ao se analisar com cuidado uma fotografia colorida num jornal). O exemplo da imagem acima usa 128 cores para descrever cada um dos pixels, a versão 'dithered', no entanto, utiliza apenas 24 cores, mas praticamente mantém a impressão visual de 'degradê' da imagem original. Há uma diferença crítica: cada ponto de cor na imagem 'dithered' tem que ser muito menor que um pixel individual. Como resultado, imagens normalmente têm que ter um DPI muito maior que o PPI para alcançar o mesmo nível de detalhe. PPI é também muito mais universal porque não requer conhecimento do aparelho para que seja possível compreender quão detalhada a impressão será.

O padrão para impressões feitas em laboratórios fotográficos é de aproximadamente 300 PPI, impressoras de jato de tinta, no entanto, precisam de muitas vezes esse número de PPI para atingir a mesma qualidade (dependendo do número de tintas usadas). A resolução da impressão depende muito da aplicação; revistas e jornais normalmente usam bem menos que 300 PPI. Quanto mais uma imagem for aumentada, menor será o seu PPI (assumindo que se mantenha o número de pixels fixo).

Megapixels e o tamanho máximo de impressão

Os famosos "megapixels" são simplesmente uma unidade de um milhão de pixels. Se partirmos do princípio de que é necessária uma certa resolução de detalhe (PPI), então há um tamanho máximo de impressão que se pode atingir para um dado número de megapixels. A tabela a seguir dá os tamanhos máximos de impressão em 200 e 300 PPI para os números de megapixels mais comuns em câmeras digitais.

| Megapixels | Tamanho máximo de impressão com aspecto 3:2 (em centímetros) | |

|---|---|---|

| a 300 PPI: | a 200 PPI: | |

| 2 | 15 x 10 | 22 x 10 |

| 3 | 18 x 12 | 27 x 18 |

| 4 | 21 x 14 | 31 x 23 |

| 5 | 23 x 16 | 35 x 23 |

| 6 | 25 x 17 | 38 x 25 |

| 8 | 29 x 20 | 44 x 29 |

| 12 | 36 x 24 | 54 x 36 |

| 16 | 41 x 28 | 62 x 41 |

| 22 | 49 x 33 | 73 x 49 |

Note como uma câmera de 2 megapixel não consegue nem produzir uma impressão padrão de 10x15 cm; e são necessários incríveis 16 megapixels para fazer uma foto de 40x25 cm. Isso pode parecer um pouco pouco desencorajador, mas não se desespere! A maioria das pessoas se contentará com impressões feitas com 200 PPI e, as vezes, até resoluções menores se a distância da qual a imagem é vista é relativamente grande. Muitos posters assumem que a distância da qual serão vistos não será menor que 15 cm, por isso são impressos em menos de 200 PPI.

Câmera e 'razão de aspecto' das imagens

| Os cálculos de tamanho de impressão acima assumiam que a 'razão de aspecto' (do inglês: "aspect ratio"), ou a razão entre a maior e a menor dimensões da imagem, fosse o padrão de 3:2 usado para câmeras de 35mm. Na verdade, a maioria das câmeras compactas, monitores e telas de TV têm um "aspect ratio" de 4:3, enquanto a maioria das câmeras SLR ("single lens reflex") usam 3:2. No entanto muitos outros formatos existem: alguns equipamentos de alto nível usam uma imagem quadrada 1:1 e filmes em DVD são alongados para o 16:9 comum em cinemas.

Isso significa que se a sua câmera usa um aspecto de 4:3, mas você precisa de uma cópia 10x15 então muitos de seus megapixels serão desperdiçados (11% para ser exato). Não se esqueça de considerar isso se a sua câmera tem um aspecto diferente daquele que deseja utilizar para as impressões. |

|

Os pixels também podem ter uma razão de aspecto, apesar de isso ser bastante incomum. Alguns padrões de vídeo e as antigas câmeras Nikon utilizam pixels com dimensões estranhas.

Tamanho do sensor: nem todos os pixels nascem iguais

Mesmo se duas câmeras tiverem o mesmo número de pixels, isso não significa necessariamente que o tamanho desses pixels é o mesmo. O principal fator que distingue uma câmera cara SLR de uma compacta barata é que a primeira tem um sensor digital de área muito maior. Isso significa que se tanto a SLR quanto a compacta tiverem o mesmo número de pixels, o tamanho de cada pixel na SLR será muito maior.

| Por que se importar com quão grande os pixels são? Um pixel maior possui maior área para agregar luz, o que significa que o sinal de luz é mais forte em um dado intervalo de tempo.

Isso normalmente resulta numa melhor 'razão sinal-ruído' (em inglês 'signal to noise ratio', SNR), o que cria imagens muito mais suaves e mais detalhadas. Mais ainda, a 'gama dinâmica' (também chamado de 'alcance dinâmico' ou 'faixa dinâmica'; do inglês 'dynamic range', o que indica a gama de luz ou escuridão que a câmera pode capturar sem que o pixel se torne completamente preto ou que ocorra um 'corte de brilhos') das imagens também aumenta com pixels maiores. Isso ocorre pois cada poço de pixels pode conter mais fótons antes de ficar cheio e se tornar completamente branco. |

Sensor em Câmeras Compactas |

|---|---|

| Sensor em Câmeras SLR | |

O diagrama abaixo ilustra o tamanho relativo de diversos sensores que normalmente são usados no mercado hoje. A maioria das câmeras SLR tem um fator de corte (em inglês 'crop factor') de 1.5X ou 1.6X (quando comparadas com câmeras de 35mm), mesmo assim alguns modelos de altíssimo nível tem um sensor do mesmo tamanho que um filme de 35mm, portanto o fator de corte é 1X (pode-se dizer também que não tem fator de corte). Os tamanhos dos sensores dados na imagem não refletem o tamanho da diagonal dos mesmos (que seria a medida tradicional usada para medir filmes), mas são os tamanhos aproximados do 'círculo de imagem' (que nem sempre é completamente utilizado). Mesmo assim, esse é o número dado na especificação da maioria das câmeras compactas.

|

Por que não utilizar o maior sensor possível? A maior desvantagem de usar um sensor grande é que eles são muito (muito) mais caros.

Outros fatores estão muito além do escopo abrangido aqui, mas o principal é que: sensores maiores requerem aberturas menores para atingir a mesma profundidade de campo, apesar de serem muito menos suscetíveis a ocorrência de difração numa dada abertura. |

Tudo isso significa que é ruim espremer mais pixels numa mesma área de sensor? Isso provavelmente causará mais ruído, mas só quando a imagem é vista no tamanho real em uma tela de computador. Na impressão real, o ruído dos modelos de muitos megapixels será muito menos notável -- apesar de parecer muito na tela (ver "Ruído em imagens: Freqüência e Magnitude"). Essa vantagem normalmente se sobrepões a qualquer aumento do ruído quando se utiliza um modelo de câmera com mais megapixels (mas, claro, há exceções).

Compreendendo o Balanço de Branco

O balanço de branco (em inglês 'White Balance' ou WB) é o processo de remoção de cores não reais, de modo a tornar brancos os objetos que aparentam ser brancos para os nossos olhos. O correto balanço de branco deve levar em consideração a "temperatura de cor" de uma fonte de luz, que se refere a quão 'quente' ou 'fria' é uma fonte de luz. Nossos olhos (e cérebros) são muito bem treinados para julgar o que é branco em diferentes situações de luz, mas câmeras digitais normalmente encontram grande dificuldade ao fazê-lo usando o ajuste de branco automático ('Auto White Balance' ou AWB). Um balanço de branco incorreto pode gerar imagens 'lavadas' com azul, laranja e mesmo verde; que são irreais e podem chegar a estragar fotografias. Para fazer o ajuste de branco na fotografia tradicional é necessário recorrer ao uso de filtros ou filmes para as diferentes condições de luz, mas, felizmente, isso não é mais necessário na fotografia digital. Compreender como o balanço de branco digital funciona pode ajudá-lo a evitar a aparição de tons indesejados gerados pelo AWB, e assim melhorar suas fotos numa grande gama de condições de luz.

|

|

| Balanço de Branco Incorreto | Balanço de Branco Correto |

Introdução: Temperatura de cor

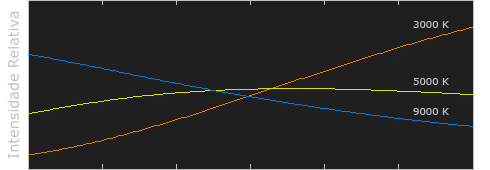

A temperatura de cor descreve o espectro de luz irradiada de um corpo negro com uma dada temperatura. Um corpo negro é, basicamente, um objeto que absorve toda a luz que incide sobre ele -- não deixando que ela seja refletida ou que o atravesse. Uma analogia bem simplificada do que pode ser um corpo negro em nosso dia-a-dia é o aquecimento de um metal ou pedra: dizemos que eles ficam vermelhos quando atingem determinada temperatura, e depois brancos quando ficam mais quentes ainda. De modo similar, corpos negros em diferentes temperaturas também têm temperaturas de cor variáveis de "luz branca". Ao contrário do que o nome pode indicar, 'branca' não necessariamente significa que a luz contém uma distribuição igual de cores ao longo do espectro visível:

A intensidade relativa foi normalizada para cada temperatura (em Kelvins).

Note como 5000K produz aproximadamente uma luz neutra, enquanto 3000K e 9000K produzem espectros luz que estão deslocados e contém mais comprimentos de onda na região do laranja e azul, respectivamente. Conforme a temperatura de cor aumenta, a distribuição de cores se torna mais fria. Isso pode não parecer muito intuitivo, mas vem do fato que comprimentos de onda mais curtos contém mais energia.

Por que a temperatura de cor é uma descrição útil da luz para os fotógrafos, se eles nunca lidam com corpos negros de verdade? Felizmente, as fontes de luz como a luz do dia e lâmpadas de tungstênio produzem distribuições de luz muito parecidas com corpos negros, apesar de outras fontes como luzes fluorescentes e a maioria dos outros tipos de iluminação seja bem diferente. Já que os fotógrafos nunca usam o termo temperatura de cor para se referir a um corpo negro de verdade, o termo mais correto seria "temperatura de cor correlata" de um corpo negro de cor similar. A seguinte tabela é um guia de correlação entre algumas temperaturas de cor e algumas fontes comum de luz:

| Temperatura de Cor | Fonte de Luz |

|---|---|

| 1000-2000 K | Luz de velas |

| 2500-3500 K | Lâmpada de Tungstênio (as mais comuns em casas) |

| 3000-4000 K | Nascer/Pôr-do-sol (céu limpo) |

| 4000-5000 K | Lâmpadas Fluorescentes |

| 5000-5500 K | Flash |

| 5000-6500 K | Luz do dia com céu claro (sol a pino) |

| 6500-8000 K | Céu levemente nublado |

| 9000-10000 K | Sombra ou céu muito nublado |

Na prática: arquivos JPEG e TIFF

Já que algumas fontes de luz não se assemelham a corpos negros, o balanço de branco utiliza uma outra variável além da temperatura de cor: o desvio verde-magenta. Ajustar esse desvio normalmente é desnecessário sob a luz do sol, mas a luz fluorescente e outros tipos de luz artificial podem precisar de um grande ajuste verde-magenta para que o resultado final da imagem seja aceitável.

| Balanço de Branco Automático | ||

| Personalizado (Custom) | ||

| Kelvin | ||

| Tungstênio | ||

| Fluorescente | ||

| Luz do dia | ||

| Flash | ||

| Nublado | ||

| Sombra |

Felizmente a maioria das câmeras digitais conta com uma variedade de valores pré-definidos para o ajuste de branco, assim não é necessário lidar com a temperatura de cor ou o desvio verde-magenta enquanto a foto está sendo feita. Os símbolos mais comuns para esses tipos automáticos de ajuste de branco estão na tabela à esquerda.

Os primeiros três ajustes podem ser usados em uma vasta gama de temperaturas de cor. "Auto white balance" (ou o ajuste automático) pode ser encontrado em qualquer câmera digital e utiliza uma algoritmo que tenta calcular a temperatura de cor dentro de um intervalo que normalmente vai de 3000/4000K a 7000K. "Custom white" balance (ou ajuste personalizado) permite que você tire uma foto de um objeto cinza de referência sob a mesma luz que a foto será feita e então ajusta o balanço de branco com base nele. Com o ajuste "Kelvin" é possível dizer a temperatura de cor em uma vasta gama.

Os outros seis ajustes estão listados em ordem crescente de temperatura de cor, mas de muitas câmeras não têm a opção de "sombra" para balanço de branco. Algumas câmeras ainda apresentam a opção "Fluorescente H", que é feita para ser utilizada com as lâmpadas fluorescentes mais recentes, que são calibradas para produzir uma luz mais próxima da luz do dia.

A descrição e símbolos para os balanços de branco listados são apenas estimativas para a luz sob a qual funcionam melhor. Na verdade, "nublado" pode gerar melhores resultados do que "luz do dia" dependendo de fatores no qual a foto é realizada tais como horário e altitude (mesmo o céu estando aberto). Em geral, se a imagem aparece muito 'fria' na pré-visualização da tela LCD da câmera, você pode diminuir a temperatura de cor selecionando um símbolo mais abaixo da lista anterior. Se a imagem continuar muito fria (ou quente se você estiver indo na outra direção), você sempre pode utilizar um valor de temperatura em Kelvin.

Se tudo isso falhar e a imagem ainda não tiver um balanço de branco correto quando inspecionada no computador, você pode modificar os ajustes de balanço de cor do programa de edição de imagens que estiver utilizando para remover predominâncias de cores indesejadas. Alternativamente, você pode utilizar a ferramenta de "Níveis" (ou Levels em inglês) e, com o conta-gotas cinza definir um novo balanço de branco. Esses métodos devem ser evitados pois reduzem drasticamente a profundidade de bits da imagem original.

Na prática: o formato RAW

De longe a melhor solução para fazer o balanço de branco é fotografar utilizando o formato RAW para as suas imagens (se a sua câmera suportar), já que através dele é possível fazer o balanço *depois* que a foto foi tirada. Arquivos RAW também permitem que o balanço seja feito com uma maior gama de valores de temperaturas de cor e desvios de verde-magenta.

Fazer o balanço de brancos em uma imagem RAW é um processo rápido e fácil. Ou você insere valores de temperatura até que a imagem não tenha nenhuma cor incorreta ou seleciona um ponto de referência da imagem (ver seção a seguir). Mesmo se só uma de suas fotos tiver um ponto de referência, é possível utilizá-lo para diversas outras que possam ter sido feitas sob as mesmas condições de luz.

Balanço personalizado: como escolher uma referência neutra

Uma referência neutra normalmente é usada para projetos onde a cor é um componente crítico, ou pra situações onde já se sabe que haverá problemas com o balanço de brancos. Referências neutras podem ou ser partes da cena (se você tiver sorte de captar uma), ou um objeto que você leva consigo. Abaixo vemos um exemplo de uma referência oportuna numa cena que poderia ter se tornado azul demais caso ela não estivesse lá.

Referências portáteis pré-fabricadas são bem mais precisas já que sempre pode-se achar que uma referência numa cena é neutra, mas ela não ser. Cartões de referência neutros especiais para a fotografia podem ser bem caros e difíceis de encontrar, mas também é possível criar um em casa que é razoavelmente aceitável. Uma referência cinza ideal é alguma coisa que reflete todas as cores do espectro da mesma forma e pode fazer isso consistentemente sob uma vasta gama de temperaturas de cor. Um exemplo de uma referência cinza é mostrado abaixo:

Uma material comum e que pode ser encontrado em casa para ser usado como referência são as partes de dentro de lacres de potes como os da batata Pringles. Esses materiais são baratos e razoavelmente precisos, apesar de referências específicas para fotografia serem, obviamente, melhores. Aparatos como esse podem ser utilizados para medir tanto a temperatura de cor incidente como a refletida do objeto sendo iluminado. A maioria das referências medem a luz refletida, mas existem aparelhos, como um medidor de balanço de branco ou "ExpoDisc" que pode medir a luz incidente (e pode obter resultados mais precisos).

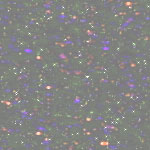

Muito cuidado deve ser tomado quando uma referência é utilizada e a imagem gerada contém muito ruído, já que clicar numa região aparentemente cinza pode, na verdade, significar clicar em uma região com pixels coloridos com o ruído:

|

|

| Pouco Ruído (Cinza suave e sem cor) |

Muito Ruído (Manchas de cor) |

Se for suportado pelo seu programa de edição, a melhor solução em um caso como esse é balancear a sua imagem utilizando um conta-gotas 'sampleado', ou que usa como base uma média de alguns pixels e não um só.

Notas sobre o balanço de branco automático

Certos sujeitos criam problemas para o aparato de balanço de branco automático das câmeras -- mesmo sob condições normais de luz do dia. Um exemplo é o de uma imagem que contém uma abundância de elementos que são de cores demasiado quentes ou frias. A imagem abaixo ilustra uma situação onde o sujeito é predominantemente vermelho, e assim a câmera acha que há uma predominância indevida dessa cor causada por uma fonte de luz quente. A câmera então tenta compensar esse fato para que a cor média da imagem seja mais próxima de um tom mais neutro, mas ao fazer isso introduz um tom azul indesejado nas pedras. Algumas câmeras digitais são mais suscetíveis a isso do que outras.

|

|

| Balanço de Branco Automatico | Balanço de Branco Personalizado |

(O balanço de branco personalizado foi feito usando um cartão de cinza 18% como referência neutra.)

O balanço de branco automático de uma câmera normalmente é mais eficiente quando a foto contém pelo menos um elemento branco. Mas, obviamente, não mude a composição da sua foto somente para que um elemento branco esteja no quadro; simplesmente tenha consciência que esse fato pode causar problemas com o balanço de branco automático. Sem o barco branco na cena abaixo o balanço de branco automático da câmera erroneamente criaria uma imagem com uma temperatura de cor levemente mais quente.

Em luz mista

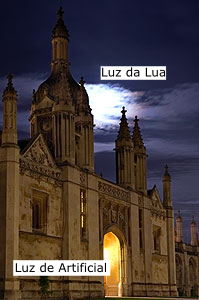

Diversos objetos iluminados com diferentes temperaturas de cor podem complicar ainda mais o quadro quando se tenta fazer o balanço de branco. Algumas situações podem até não ter um balanço de branco 'correto', e este vai depender de onde a fidelidade de cor é desejada.

|

||

| Referência: | Lua | Pedras |

Sob luz mista, o balanço de branco automático normalmente calcula uma temperatura de cor média para a cena inteira e usa esse valor para determinar o branco. Essa abordagem pode até ser aceitável, mas o modo automático tende a exagerar a diferença em temperaturas de cor para cada fonte de luz quando comparado com o que vemos com os nossos olhos.

As diferenças exageradas costumam ser mais aparentes quando há uma mistura de luz interior e exterior. Imagens críticas podem vir a necessitar de balanços de branco diferentes para cada região de luz. Por outro lado, algumas pessoas preferem o 'efeito' causado nesses casos e deixam o balanço como está.

Note como o prédio ao lado está quente enquanto que o céu está um tanto frio. Isso acontece pois o balanço de branco foi calculado com base na luz da lua -- o que realçou a temperatura de cor quente da luz artificial do prédio. Um balanço baseado em luz natural normalmente resulta em imagens mais reais. Escolha "pedra" como base para o balanço de branco para verificar como o céu se torna demasiado azul e irreal.